AI驱动的计算成像技术为无人机遥感等资源受限场景提供了一种轻小型化红外成像新路径。然而,现有的神经网络重建模型普遍存在计算复杂度高、延迟大、能效低的问题;且其算法优化过程往往侧重于以PSNR和SSIM为代表的图像质量指标,而忽视了以MTF为代表的光学性能约束,导致难以满足实际应用中对视频级图像的高性能重建需求。针对这一问题,同济大学物理科学与工程学院王占山教授与程鑫彬教授团队提出了一种面向单片式红外计算成像边缘重建的轻量级图像复原框架——MWR-Net。该框架以MobileNetV4为骨干优化下采样策略,引入小波域损失函数以增强高频细节恢复能力,并融合MTF作为光学保真度评价指标,实现算法与成像系统性能的深度对齐,在RK3588边缘平台上实现了高质量细节保留与低推理延迟的平衡。相关研究成果以“MWR-Net: An Edge-Oriented Lightweight Framework for Image Restoration in Single-Lens Infrared Computational Imaging”为题,发表于成像科学与照相技术二区期刊《Remote Sensing》,为资源受限平台下的视频级的红外遥感成像奠定了技术基础。

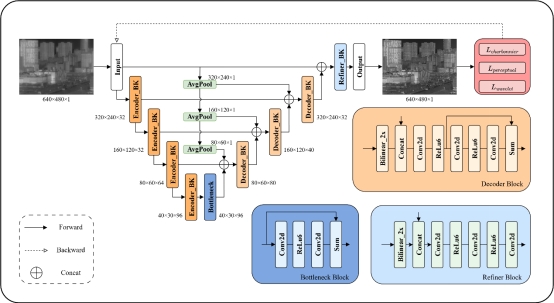

图1 MWR-Net整体结构框架

MWR-Net框架借鉴MobileNetV4-Small构建。编码器采用深度可分离卷积单元,构建了四级特征金字塔:前两阶段保持高分辨率与较少层数,后两阶段逐步降低分辨率并增加深度,可以显著减少激活张量内存占用,缓解边缘设备内存瓶颈。解码器引入多尺度特征融合与通道扩展机制以增强重建能力,最终通过细节优化模块进一步提升纹理恢复效果。整体架构如图1所示。

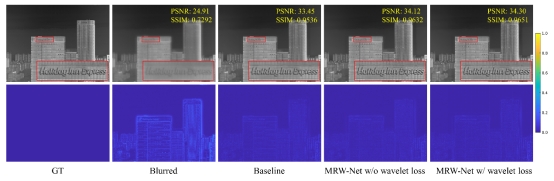

图2 不同模型的图像重建结果及其与真值的误差热力图对比

实测结果表明,MWR-Net在大幅降低参数量和计算开销的同时,仍可以保持优异的重建性能,实时重建速度达42 fps。如图2所示,通过引入小波域损失函数并结合MTF指标优化,该网络显著增强了高频细节恢复能力,在全视场实现了奈频处MTF优于0.5,实现了边缘性能与重建速度的良好平衡。

同济大学为论文第一单位,同济大学助理教授王绪泉为论文通讯作者,硕士生钱玄宇为论文第一作者,对论文做出重要贡献的合作者还包括同济大学的王占山教授、程鑫彬教授、顿雄副教授和博士生邢裕杰、杨桂烁。

论文链接:https://doi.org/10.3390/rs17173005